- Imprimer

- Partager

- Partager sur Facebook

- Partager sur X

- Partager sur LinkedIn

Communiqué / Innovation, Eq B.Yvert

Le 6 février 2026

Une équipe du Grenoble Institut des Neurosciences a développé un réseau de neurones artificiels biomimétique extrêmement simple, capable d’identifier automatiquement des motifs temporels complexes dans des signaux neuronaux multicanaux. Une solution originale pour traiter en temps réel les flux massifs de données générés par les nouvelles interfaces neuronales.

Les implants neuronaux de nouvelle génération intègrent des centaines, voire des milliers d’électrodes, produisant un volume considérable de données.

L’une des étapes clés de leur exploitation est le spike sorting, qui consiste à distinguer l’activité de neurones individuels à partir des signaux enregistrés par plusieurs électrodes voisines. Les méthodes actuelles, souvent performantes, reposent sur des algorithmes gourmands en calcul qui peuvent difficilement être incorporés dans des implants à très basse consommation.

Une approche radicalement simplifiée

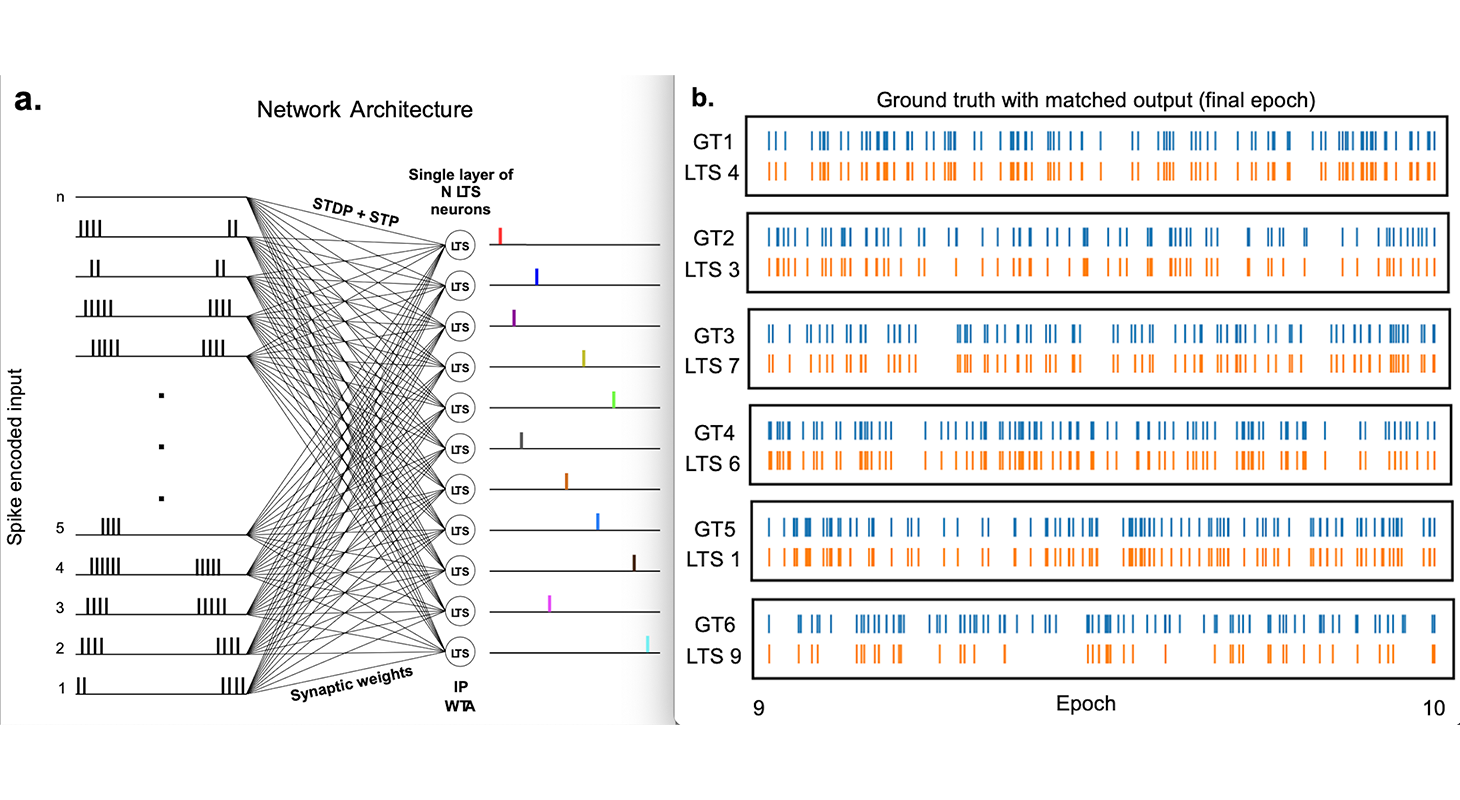

Dans un article publié dans Nature Communications, Blaise Yvert et son équipe « Neurotechnologies et Dynamiques des Réseaux » proposent une architecture de réseau de neurones à impulsions (Spiking Neural Network, SNN) volontairement minimaliste.

Les SNNs, réseaux artificiels de 3e génération, se distinguent des réseaux de neurones profonds classiques de 2e génération par le fait qu’ils intègrent une dynamique temporelle mimant celle des neurones réels. Alors qu’une architecture précédemment développée par l’équipe permettait de traiter le signal d’une seule électrode avec un réseau attentionnel multicouche, ce nouveau SNN ne comporte qu’une seule couche et seulement quelques neurones artificiels, pour traiter plusieurs signaux simultanément tout en étant capable d’apprendre de manière autonome.

Le principe repose sur des neurones dits Low-Threshold Spiking (LTS), dont la dynamique particulière leur permet d’« attendre » la fin d’un motif temporel avant de produire une impulsion. Chaque neurone du réseau apprend ainsi à reconnaître un motif spécifique dans un flux de données multivoies, sans connaissance préalable ni phase d’apprentissage supervisé.

L’apprentissage s’effectue à l’aide de règles locales inspirées de la plasticité synaptique biologique, ce qui limite drastiquement les besoins en mémoire, en calcul, et en nombre de données nécessaires à l’apprentissage.

Des performances démontrées sur des données réelles

L’algorithme a été testé sur différents types de données : signaux simulés, sons de la parole, activités neuronales multicanaux, ainsi que des jeux de données de spike sorting simulés et réels.

Dans ce dernier cas, le réseau parvient à identifier et classer automatiquement les potentiels d’action de neurones distincts, avec des performances comparables à certaines méthodes de référence, tout en utilisant une architecture compatible avec un calcul frugal.

Vers des implants intelligents et sobres en énergie

« L’idée est de disposer d’algorithmes suffisamment simples et économes pour pouvoir, à terme, être intégrés directement dans des implants neuronaux » explique Blaise Yvert.

Si les résultats présentés reposent encore sur des simulations, cette approche est nativement compatible avec des puces neuromorphiques, spécialement conçues pour exécuter des réseaux de neurones à impulsions sous très basse consommation.

À terme, ce type d’algorithme pourrait permettre de traiter et de sélectionner l’information directement au plus près du cerveau, réduisant considérablement les flux de données à transmettre et ouvrant la voie à des implants neuronaux plus intelligents intégrant non seulement le recueil des signaux mais également une extraction automatique de leurs caractéristiques importantes.

Référence :

A frugal Spiking Neural Network for unsupervised multivariate temporal pattern classification and multichannel spike sorting

Sai Deepesh Pokala, Marie Bernert, Takuya Nanami, Takashi Kohno, Timothée Lévi & Blaise Yvert

Nature Communications vol. 16, Article number: 9218 (2025)

Date

- Imprimer

- Partager

- Partager sur Facebook

- Partager sur X

- Partager sur LinkedIn